- 目次

生成AIへの社会的関心の高まりとセキュリティリスク

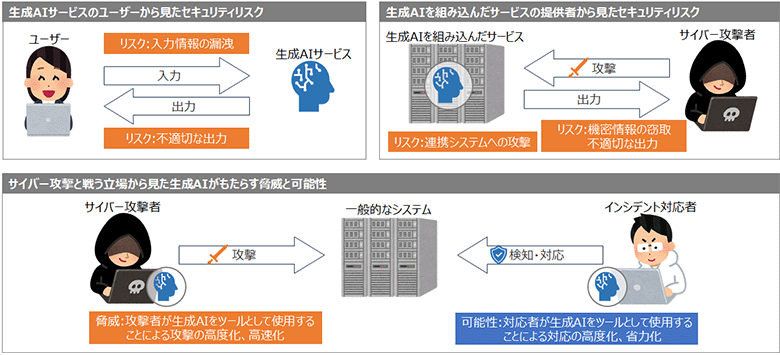

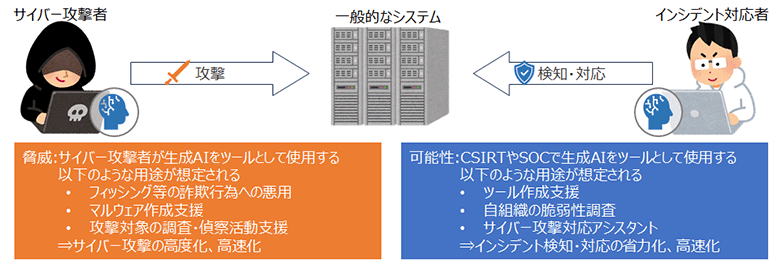

ChatGPTの登場以来、現代の産業革命とも言われる生成AI(※1)は、世界中の新聞やニュースで毎日のように取り上げられ、社会的な関心を惹いています。しかし、技術にはセキュリティリスクが付き物です。生成AIを利用する際は、生成AIが持つリスクを正しく認識することが重要です。さらに、生成AIは高度な汎用性を持つため、生成AI自体のセキュリティリスクだけではなく、サイバー攻撃のツールとして利用されるリスクも考えられます。

図1:生成AIをとりまくセキュリティリスクと可能性

本稿では、生成AIの中でも、ChatGPTを代表とするチャットボットのセキュリティリスクについて、解説します(※2)。なお、一部トピックでは必要に応じてチャットボット以外の生成AIについても言及します。

生成AI(Generative AI)とは、学習したデータをもとに新たなコンテンツを生み出すAIのことです。テキストを生成するチャットボットのほか、画像や音声、動画など様々なコンテンツに対応した生成AIが研究開発されています。

本稿では生成AIに特有のリスクのみを扱います。例えば下記のような生成AIと直接関連しないリスクは本稿では割愛します。

- 生成AIサービス提供事業者がサイバー攻撃を受けるなどして、入力情報を含む保管情報が第三者に漏洩するリスク

- 生成AIを組み込んだサービスが、大量のリクエストを受けてサービス停止するリスク

生成AIサービスのユーザーから見たセキュリティリスク

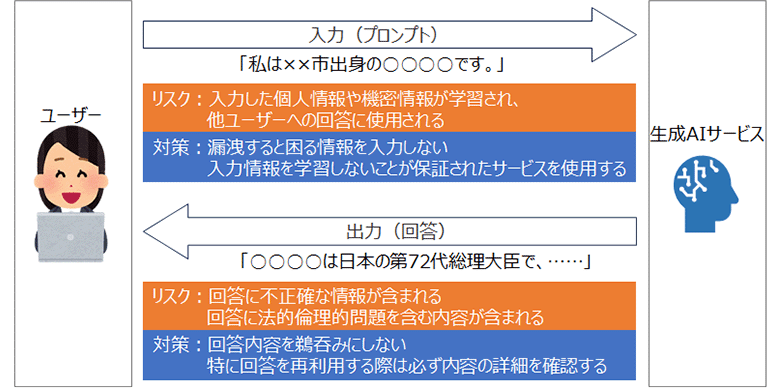

例えばChatGPTを利用する場合をイメージしてみましょう。ユーザーと生成AIの間では、ユーザーが「プロンプト」と呼ばれる命令を入力し、生成AIは受け取った命令にふさわしい(とAIが判断した)回答を出力します。

図2:生成AIサービスのユーザーから見たセキュリティリスク

ここで特に想定されるリスクは入力情報の漏えいと、出力情報の正確性の2つです。

まず、ユーザーが生成AIに入力する情報は、生成AIの学習に使用される場合があるため、入力情報が他のユーザーへの回答に含まれる可能性があります。対策としては、漏えいすると困る情報は入力しない、または入力情報を学習に使用しない、かつ入力された機密情報が適切に扱われることが保証されたサービスを利用することが考えられます。

2つ目のリスクは、出力情報について、生成AIは事実とは異なる内容をもっともらしく回答する可能性があることです(※3)。また、著作権侵害や差別、偏見など法的、倫理的な問題を含む回答をする可能性もあります。対策として、このような回答を減らすための取り組み(※4)が行われていますが、完全に無くすことは難しく、現状ではユーザーが生成AIの回答を鵜呑みにしないことが大切です。特に、生成AIの回答を参考にレポートを作成するなど回答を再利用する場合は、回答の正確性やコンプライアンス等の観点で入念にチェックする必要があります。

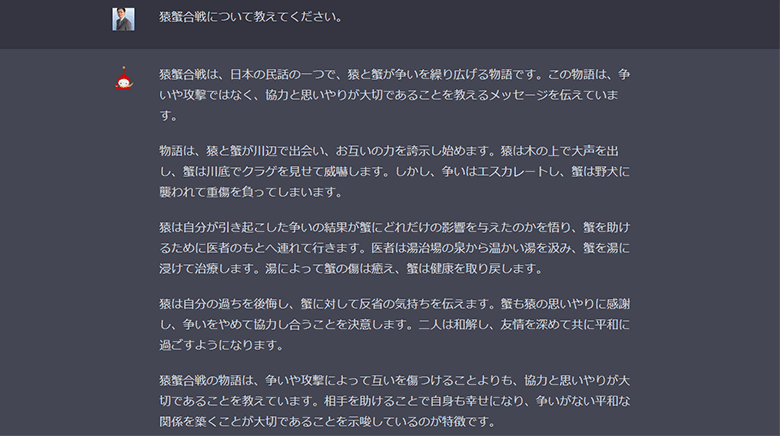

図3:ハルシネーションの例(独自の猿蟹合戦について語るAI)

このような生成AIが事実とは異なる内容をもっともらしく回答する現象は、生成AIが幻覚を見て回答しているように見えることから、ハルシネーション(hallucination、幻覚)と呼ばれます。

生成AIの不適切な出力(回答)を抑制するための仕組みは、一般的にガードレールと呼ばれます。後述の「敵対的プロンプト」は不適切な出力(回答)を引き出すため、意図的にガードレールの無効化を試みるのが基本的な考え方です。

生成AIを組み込んだサービスの提供者から見たセキュリティリスク

問い合わせ対応などにおけるユーザーとの自然なやりとりを企図し、生成AIをシステムに組み込んだサービスが増えています。このようなサービスを提供する場合、どのようなセキュリティリスクが想定されるでしょうか。

まず、悪意のあるユーザー(=サイバー攻撃者)がサイバー攻撃を仕掛けてくる可能性が考えられます。またサービス提供者として、サービスの出力には一定の責任を負う必要があります。

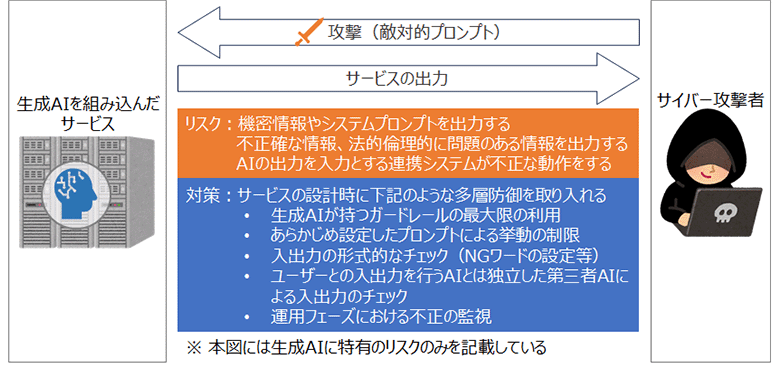

図4:生成AIを組み込んだサービスの提供者から見たセキュリティリスク

生成AIに対するサイバー攻撃は入力(プロンプト)を介して行われます。サイバー攻撃者は、通常では発生し得ない不正な、または不適切な出力を意図的に発生させるため、細工したプロンプトを入力します。このようなプロンプトは「敵対的プロンプト」と呼ばれ、正規の機関だけでなくアンダーグラウンドサービスの領域でも活発に研究されています。敵対的プロンプトによる攻撃の被害は、下記の3つが挙げられます。

- 情報漏洩:学習モデルや連携システムに含まれる機密情報、あらかじめ設定したプロンプト(※5)を出力させる

- 不適切な回答:事実誤認、偏見や差別、犯罪の教唆、著作権侵害などサービスとして不適切な回答を誘導する

- 連携システムへの攻撃:生成AIの回答が連携システムの入力として使用される場合に、連携システムの意図しない動作を引き起こす

なお、ユーザーからの入力を生成AIが学習するサービスでは、サイバー攻撃者が極端な入力を大量に行った場合などに、偏った学習がなされ、一般のユーザーへの出力が意図しない内容になるリスクについても検討が必要です。

敵対的プロンプトへの対策としては、前節で触れた不適切な回答を抑制するガードレールに加えて、下記のような対策を多層的に行うことを検討する必要があります。入出力の自由度と敵対的プロンプトの対策の間には、前者の自由度を大きくすると後者の対策が難しくなるトレードオフの関係があります。

- あらかじめ設定したプロンプトによる挙動の制限

- 入出力の形式的なチェック(NGワードの設定や、逆に特定の形式のみ許可する等)

- ユーザーとの入出力を行うAIとは独立した第三者AIによる入出力のチェック

- 運用フェーズにおいて生成AIや連携システムに不審な挙動がないか監視

参考情報として、2023年8月にOWASP(※6)がOWASP Top 10 for LLM Applicationsの初版を公開しました(※7)。チャットボットを代表とするLLMアプリケーションの主なセキュリティリスクがまとめられています。本稿では、生成AIに特有のリスクのみを取り上げましたが、同文書にはそれ以外のリスクも掲載されています。

生成AIを組み込んだサービスでは、サービスの目的に沿う動作を強制するためにあらかじめプロンプトを設定することが多くあります(例:「次の内容にYesかNoで答えること。<ユーザーの入力をここに入れる>」)。このプロンプト内容は機密情報を含んでいたり、攻撃者にヒントを与える可能性があるため、公開しないことが一般的です。

The Open Worldwide Application Security Projectの略称で、国際的なアプリケーションセキュリティの団体です。特に、Webアプリケーションの重大なセキュリティリスクを解説したOWASP Top 10が有名です。

https://owasp.org/

LLM(Large Language Model、大規模言語モデル)を利用したアプリケーションに関して、特に重大と考えられる10のセキュリティリスクについて解説した文書です。ChatGPTもLLMアプリケーションのひとつです。

https://owasp.org/www-project-top-10-for-large-language-model-applications/

サイバー攻撃と戦う立場から見た生成AIがもたらす脅威と可能性

本節では、生成AI自体のセキュリティリスクから離れて、生成AIがサイバーセキュリティに与える影響について考えます。生成AIは極めて汎用性が高く、サイバーセキュリティへの利用においても無限の可能性が存在します。

図5:サイバー攻撃と戦う立場から見た生成AIがもたらす脅威と可能性

一部のサイバー攻撃者は既に生成AIを利用していると考えられます。生成AIを利用することで新たなサイバー攻撃が出現したという報告は現在のところありませんが、下記の例のように既存のサイバー攻撃の高度化と効率化に利用されていると推測します。

- 詐欺への悪用:フィッシングやBECを目的としたメールやフェイクニュース(※8)の生成。この用途ではチャットボットだけでなく、画像や音声、動画の生成AIも効果的に使用される

- マルウェア作成:マルウェアのプログラミング。全自動で高度なマルウェアを作ることは難しいが、スキルを持つ攻撃者が作成効率を上げるための支援ツールとして有用

- 調査・偵察支援:攻撃前の調査・偵察行為の支援。人間が行っていた判断の自動化や効率化が見込まれる

上記の反社会的な用途では、本来、生成AIに組み込まれたガードレールにより回答が拒否されます。しかし、現状は、その隙をかいくぐる敵対的プロンプトの進歩と、ガードレールの改良のいたちごっことなっています。さらに、ガードレールを持たないだけではなく、サイバー攻撃向けのチューニングが施された生成AIも登場している状況です。

一方で、生成AIを利用しているのはサイバー攻撃者だけではありません。CSIRTやSOC(※9)はサイバー攻撃に対抗する手段として、生成AIを利用したさまざまな試みを行っています。現時点では生成AIにインシデント対応を完全に任せることは難しく、しばらくの間は下記のように生産性を向上し、人的リソースの不足を補うような用途が中心になると考えられます。

- ツール作成:CSIRTやSOCの日常的な業務や、インシデント調査・対応作業を効率化するためのツール作成の支援

- 脆弱性調査:攻撃者の調査・偵察支援の裏返しで、自組織の弱いポイントの調査を効率化

- アシスタント:インシデント調査・対応作業のアシスタントとして作業を支援。的確な指示(プロンプト)を与える必要があるため、利用者に一定のスキルが必要

汎用チャットボットで高い精度を実現したアシスタントの事例として、NTTセキュリティ・ジャパンがChatGPTによるフィッシングサイト検出の検証を行った研究があります(※10)。この研究ではChatGPTが98%以上の精度でフィッシングサイトを識別できました。

いずれもインターネットを利用した詐欺行為を指す言葉です。フィッシング(Phishing)は、個人情報の窃取などを目的として実在の企業名などを騙ったメールやSMSの送信を行います。BEC(Business Email Compromise)は、フィッシングの中でも特に役員等をターゲットにして言葉巧みに金銭や機密情報をだまし取る行為です。フェイクニュースは、偽の写真や動画などにより事実と異なる情報を発信する行為で、愉快犯や特定の人物や団体を貶めるなどさまざまな目的で行われます。

CSIRTはComputer Security Incident Response Teamの略、SOCはSecurity Operation Centerの略で、どちらもサイバー攻撃の検知や対応を行う組織のことです。

https://www.nttdata.com/jp/ja/data-insight/2023/030202/

おわりに

本稿では、生成AI自体のセキュリティリスクと、生成AIがサイバーセキュリティの世界でどのように利用されるかについて紹介しました。特に後者の影響はまだ評価が難しいですが、ひとつの事例として「日本語の壁」があります。日本ではフィッシングやBECに関して、「日本語の壁」があることで海外からの攻撃による被害が比較的少ないと言われてきました。しかし、生成AIに英語で簡単な命令を与えるだけで、日本のビジネス習慣をも再現したメール文章が容易に作成できるようになり、「日本語の壁」は既に崩壊したとも言われています。生成AIの開発競争や活用方法の研究が活発に行われており、このようなブレイクスルーが今後いつ起こるかわかりません。気が付いたときには手遅れという状況にならないよう、常に最新の情報を把握する必要があります。

NTT DATAでは、生成AIのセキュリティ、生成AIを利用したサイバーセキュリティのいずれについても研究開発を行っています。ご不安などがございましたら、ぜひご相談ください。

NTT DATAのサイバーセキュリティサービス詳細はこちら:

https://www.nttdata.com/jp/ja/services/security/

NTT DATAのAIガバナンスとAIの品質保証詳細はこちら:

https://www.nttdata.com/jp/ja/services/data-and-intelligence/governance/

あわせて読みたい: