1.生成AIの特性

業務の自動化や効率化のため、生成AIの導入がさまざまな場面で検討されています。検討の第一歩として、生成AIと対象の業務にどの程度親和性があり、どの部分なら生成AIに任せられるかを整理する必要があります。

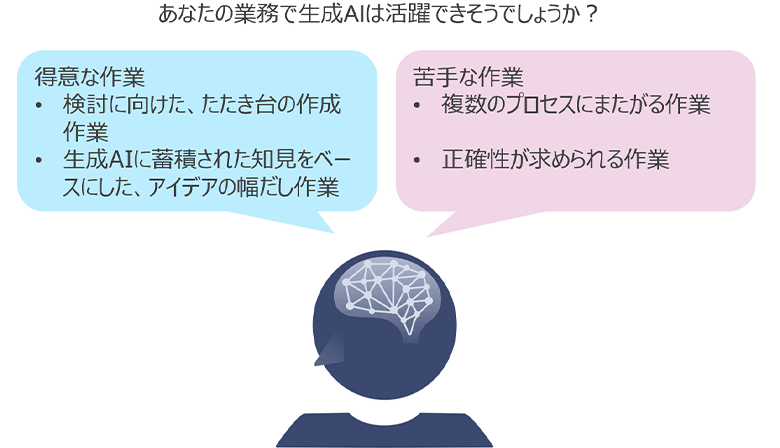

生成AIが得意とするものは

- 生成AIがたたき台を作成し、質問者はそれを元に最終形を作成することでアウトプット作成までの時間を短縮する

- 生成AIに蓄積された知見をベースにアイデアの幅だしができる

などが挙げられます。しかし、以下に挙げるような不得意なこと、問題点もあります。

- 複数のプロセスにまたがる仕事は指示できない

- 間違いや不適切なことを自信たっぷりに回答する(ハルシネーション)

こうした特性を踏まえると、生成AIの活用に適しているのは以下の前提条件を満たす業務であると考えられます。

- 生成AIのアウトプットに対し、網羅性や正確性に関する厳密さを求めない

- 生成AIのアウトプット品質を命令者が判定できる

上記を踏まえ、生成AIが自分の抱える業務の役に立つかを考える必要があります。皆さんの業務に照らし合わせてみるといかがでしょうか?

図1:生成AIの得意な作業、苦手な作業

2.リスク分析、対策設計の現状

リスク分析や対策設計などのサイバーセキュリティに関わる上流業務は、攻撃の高度化や被害の増加に伴い重要度も増しています。しかし、こうした業務を行えるセキュリティ有識者は限られており、かつ、有識者でも時間がかかる作業となっています。

主な要因として、

- 技術的なもの以外にも、法制度やビジネス要件、予算、スケジュールなど複雑な要因が組み合わさっており、OK/NGを機械的に決められない

- それぞれの要因に対して、網羅的かつ正確に検討を行うことが求められる

といった点が挙げられます。そのため、現状は経験を積んだ有識者がアウトプットの最終チェックを行い、品質の確保を行っています。

3.リスク分析、対策設計へ生成AIを導入する際のハードル

前述の状況を踏まえると、リスク分析や対策設計は生成AIが苦手としている作業が多く含まれており、残念ながら現時点では生成AIを導入するハードルが高いと考えられます。

実際、当社が行ったOpenAI社のChatGPT‐3.5を使った検証において、有識者自身でリスク分析・対策検討を行った場合とChatGPTがリスク分析・対策検討を行い、アウトプットを有識者が確認した場合とを比較しましたが、後者の場合でも有識者の作業時間を削減することはできませんでした。

検証は、リスク分析や対策設計を行うプロセスをタスク単位へ分解し、各タスクの消化に要する工数の削減効果について測定する形で行いました。例えば、複数存在する対策案のなかからシチュエーションに合ったベストな対策案を選択するというタスクを実行させるためのプロンプトをChatGPT‐3.5に繰り返し入力したところ、入力するたびに異なる対策を提示する場合がありました。他にも、ChatGPT‐3.5にレビュアーとしての役割を与え、作業者による判断の妥当性を判定させるというタスクを実行したところ、プロンプトの作り方に依存する部分はあるものの、明らかに両立しない判断に対しそれぞれ妥当であるとの判定を下す場合がありました。

以上の結果から、これらタスクをChatGPT‐3.5へ任せたとしても、有識者がアウトプットの妥当性を検証しなければならず、作業時間の削減に繋がらないことが分かりました。

4.リスク分析、対策設計への生成AIの導入にむけた見通し

では今後も、リスク分析や対策検討を生成AIに任せられないのでしょうか。前述の通り、現状は生成AIが作成したアウトプットを有識者がチェックする時間がネックであることが分かったため、まずはチェックの負荷軽減が挙げられます。チェックの負荷軽減をするための対策としては、大きく

- 生成AIのアウトプット品質をあげる

- アウトプットのチェックを自動化する

の2点が挙げられますが、いずれの対策も本質的にはチェックの手順と判断基準を定式化し、生成AIに学習させることが前提となります。

チェック手順については、例えばセキュリティの3要素である機密性、可用性、完全性の観点で検討されているか、技術面だけでなく、運用面、体制面、管理面でも検討がされているか、など具現化することは可能と考えられます。しかし、判断基準は確固として定義されるものはなく、例えばビジネスや会社自体の規模、スケジュール等のさまざまな検討観点を適宜選定した上で判断されるため、定式化は困難と考えます。そのため、現在、研究が行われている汎用人工知能(AGI、Artificial General Intelligence)の実用化などのブレイクスルーがない限り、当面こうした作業は人手のままとなりそうです。

…と、生成AIがリスク分析や対策設計に馴染まない点ばかりを挙げてしまいましたが、生成AIがリスク分析や対策検討が全くできないかというとそうではありません。実際、ChatGPT‐3.5でリスク分析を行わせたところ、システムの特性を踏まえきちんと分析が行えた箇所も少なからず見られました。そのため、リスクが低いと判断できるものには、生成AIの作成したアウトプットに嘘や誤りがないかなど最低限のチェックを行うのみにとどめ、それ以外のリスクを許容しアウトプットを受け入れるといった事例が今後生まれるかもしれません。

NTT DATAのシステム開発における生成AI活用事例についてはこちら:

https://www.nttdata.com/jp/ja/data-insight/2023/1116/

NTT DATAのサイバーセキュリティに関するサービス詳細はこちら:

https://www.nttdata.com/jp/ja/services/security/

NTT DATAのAI(人工知能)に関するサービス詳細はこちら:

https://www.nttdata.com/jp/ja/services/data-and-intelligence/governance/

あわせて読みたい: