1. AI活用の広がりと課題

オンラインショッピングやマッチングアプリのような身近なサービスから、ローン審査といった人生を左右する業務にまでAI(人工知能)が活用される今日、AIの活用にはますます高い信頼性が求められます。しかしAIの「偏見やステレオタイプを含む不適切な推論」が社会的な問題となるケースも少なくありません。

例えば、米国各州における「COMPAS」という再犯予測システムは、アフリカ系アメリカ人の被告に対して不利な判定をすると分かり、大きな社会問題となりました。著名なIT企業の人事採用システムが、ソフトウエアエンジニアなどの技術職を採用する際に、女性に対して不利なスコアを算出することが分かって、利用が停止されたこともあります。商用の顔認証システムが特定の人種に対して精度が低くなる問題も明らかになり、提供を取りやめたケースもあります。

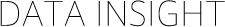

このような社会的背景から、AIを利活用する上では従来のように精度だけを追い求めるのでは不十分で、その活用がもたらす結果を多角的な視点で確認する必要があります。本記事では、近年特に注目されている「AIの公平性」に焦点を当て、検証した内容を紹介します。

図1:AI活用への要求の拡大

2. AIに求められる公平性

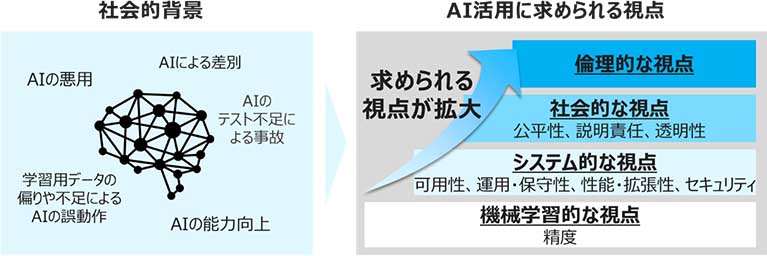

AIは実際のデータから規則性を学習するため、その判断には現実に起きた歴史的・社会的な差別の結果を色濃く残すことがあります。さらにデータの選び方や学習アルゴリズムなどにより、その差別がより強化されてしまうこともあります。

図2:不公平な予測に影響するバイアスの例

このため、AIシステムを活用するユーザ・企業は、AIによる不当な差別がされないよう十分に配慮しなければなりません。欧州委員会による「Ethics guidelines for trustworthy AI(信頼できるAIの倫理指針)」や、内閣府による「人間中心のAI社会原則」や総務省による「AI利活用ガイドライン」などでも、AIの公平性に対する要求が明記されています。

一方、これらのガイドラインでは考慮すべきポイントは示されているものの、具体的な取組内容については各ベンダーに委ねられており、標準的な手法は確立されていません。

このためNTTデータでは、過去のAI開発で得られたノウハウや外部有識者のアドバイスをもとに、信頼できるAIの実現に取り組んでおり(※)、このたび、AIの公平性にいち早く取り組むIBMと協働で、AIのシステム開発における公平性の担保方法について検証しました。

https://www.nttdata.com/jp/ja/-/media/nttdatajapan/files/services/ai/ai-development-methodology.pdf

3. IBMの取組

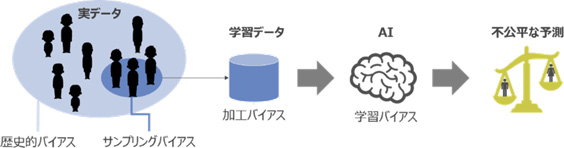

IBMでは、信頼されるAIの実践のために、2017年からAI倫理のガイドラインを策定し、AI指標の体系化に取り組んできました。公平性、説明性、ドリフトといった観点で機械学習モデルのバイアスを検知・モニターするソリューションとしてIBM Watson OpenScale(以下、OpenScale)を展開しており、海外の金融機関でのリスク対応やイベントでのAI画像解析におけるユースケースを実現しています。

図3:Watson OpenScaleの主要機能

4. 検証

今回はAI開発プロセスに則った品質管理項目のうち、まだ手法が確立していない公平性の監視およびバイアス緩和についてOpenScaleを用いた実現方法について検証しました。

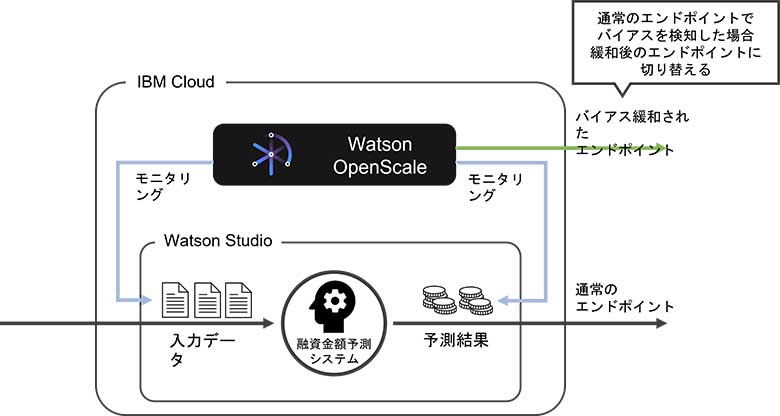

本検証では、「個人の情報をもとに融資可能な金額を推定するAIモデル」を作成し、それをIBM Cloud Watson Studio上にデプロイし、OpenScaleを用いて監視を行います。OpenScaleはモデルに入力されるデータおよびその予測結果を収集し、公平性の監視を行います。もしデプロイされたモデルに問題がある場合、モデルを切り替えることで公平な推論結果を保つことが見込めます。

なお本検証に使用したデータは実際のデータを想定したダミーであり、実際の業務への活用には一切使用しておりません。

図4:検証用AIモデル

図5:検証概要

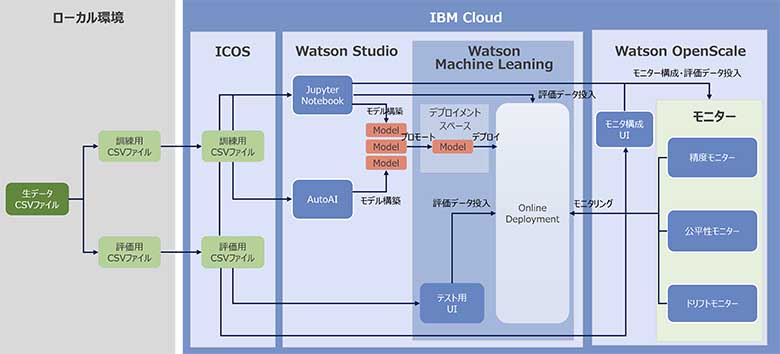

図6:IBM Cloud上の検証環境

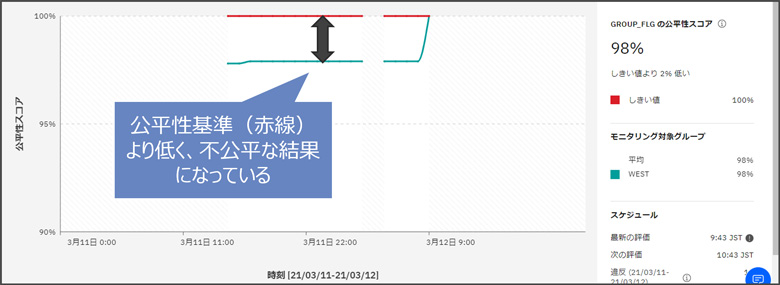

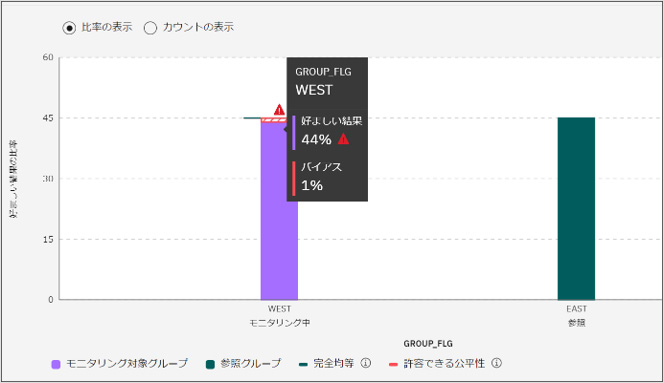

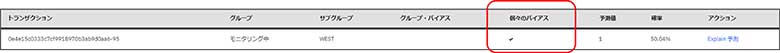

まず、OpenScale の公平性モニター機能を用いて公平性スコア(Disparate impact)を評価したところ、東部の住民に比べ西部の住民の融資金額が少ない(=好ましい結果の割合が少ない)、すなわち不利な結果になっていることが確認できました。

図7:公平性スコアの継続的監視

図8:特定の時間における公平性スコアとバイアス検知

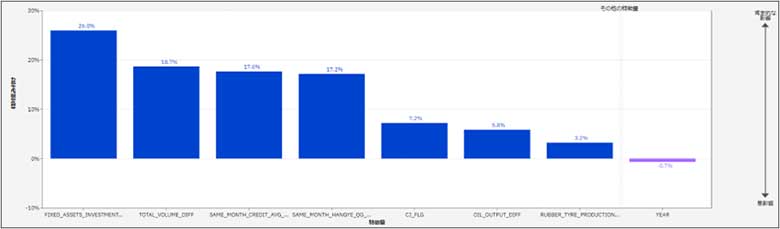

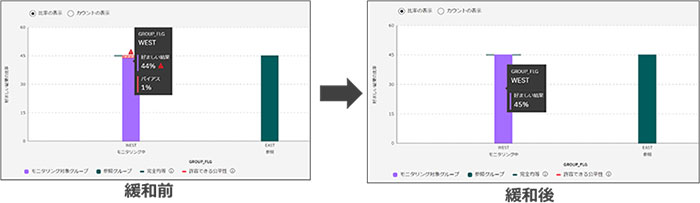

今回構築したモデルには西部の住民に不利なバイアスがあることがわかったので、次にこのバイアスをOpenScaleにて緩和できるか検証しました。OpenScaleは各トランザクションに対してLIMEによる予測結果の解釈を行い、それに基づいてバイアスを生じさせるトランザクションを特定します。

図9:バイアスの原因であるトランザクション

図10:LIMEによる特徴量の重要度の可視化

図11:バイアスの緩和と公平な結果

このように緩和後のモデルはバイアスが取り除かれており、西部と東部で同等な結果にすることができました。なお、この操作はSDKやAPIからだけでなく、Web UIから簡単に実施することができ、バイアス緩和されたモデルも自動的にWeb APIが作成されるため、公平なモデルへすぐアクセスすることができました。

5. まとめ:これからのAI公平性担保

本検証を通して「公平かつ信頼できるAI」の実現に不可欠な、公平性の担保・評価手法を確認しました。今後は検証結果をもとに開発プロセスをアップデートし、実際のプロジェクト現場で活用できるよう具体化を進めます。

NTTデータでは、人間とAI(人工知能)が共生する「より豊かで調和のとれた社会」の実現に貢献するため、これからもAIガバナンスに関する取り組みを拡大・継続してまいります。日本IBM様とは今後とも双方の強みを活かして、国内外のAI品質の向上に貢献していきたいと考えています。