- 目次

AIアドバイザリーボードについて

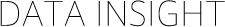

2021年4月に、社会デザイン・ソフトウェア工学/法務・倫理/リスクマネジメント・SDGsなどさまざまな分野の社外有識者からなる「AIアドバイザリーボード」を設立しました。本ボードはAI利活用に関する技術動向、法令・規制、市民社会の認識について、有識者と幹部マネジメント層及びAIプロジェクトに関わる現場最前線のメンバーが議論をし、その結果をAIガバナンスの具体的な手段に取り入れていくことを目的としており、第一回勉強会(※2)では「政策動向を意識したAI活用」について議論し、第二回勉強会(※3)では「AIが浮き彫りにしたプライバシーと差別の課題」について議論し、今回第三回の開催に至りました。

図1:AIアドバイザリーボードの実施体制(外部有識者メンバーと運用)

AIシステムの品質と倫理~開発者・技術者の立場から~

第三回勉強会では、国立情報学研究所の石川冬樹先生が「AIシステムの品質と倫理」について講演しました。

石川先生

(1)品質管理の枠組み

従来のシステムやソフトウェアにおける品質の考え方と、これまで定義されてきた品質に関する枠組み・評価手法・標準などについて解説されました。そしてAIにおいても、安定性や継続的改善のために、品質を測定可能な形で具体化・定型化することが必要であることを述べられました。

また、AIの学習にはバランスが求められるため、場合分けを適切に行い、適切な分量と種類を学ばせる必要があること、そしてAIが想定通りに動いているか/入出力の傾向が変わっていないか、を定常的にテストし続ける必要があることを解説されました。

(2)AIの品質とXAI(Explainable AI:説明可能AI)

機械学習におけるブラックボックスの問題について、深層学習はどういった計算をしているかは明確なものの、構造が複雑過ぎて解釈できなくなっており、人が理解できる表現に直して説明を付けることになる現状について述べられました。例えばAIが画像を「狼」だと判断した場合、どこを見て判断したのか、根拠や判断基準(どういった学習をした結果としてその判断基準になったのか)を提示する技術が整備されてきていることを話されました。なお、実態を正確に表現していなくても、それらしい説明になっていれば人は満足するという懸念が出ていることにも言及し、XAI分野の技術は確実に進化しているが、安易に説明を求めたり付与したりせず、場面に応じて個別に判断していく必要がある、とまとめられました。

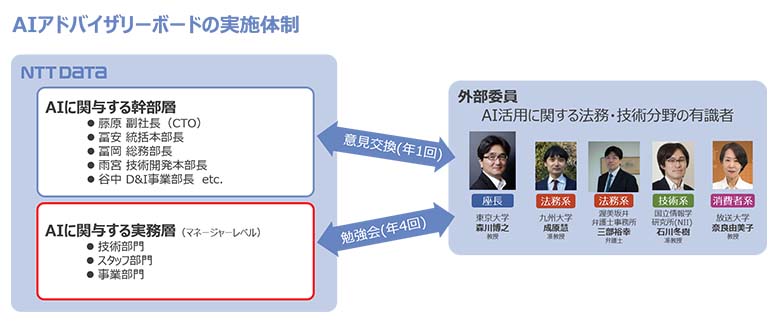

(3)AIの公平性

社会的に望ましくないバイアスが発生することを避けるため、ノイズとなるデータはAIに学ばせない方が良い場合があることを再度説明されました。また、採用の判断や医療における治療優先度を決定するAIでは、それまで人々が無意識的に行っていた差別をAIが学習し、明示的な差別を顕在化させてしまう、すなわち曖昧だった不公平がAIによって顕在化されうる、と述べられました。このため、今後は現実に起きうる様々なケースに合うよう、AIを活用した意思決定の在り方を具体化・再定義していく必要がある、との見解を示されました。

図2:「AIシステムの品質と倫理」講演資料サンプルイメージ

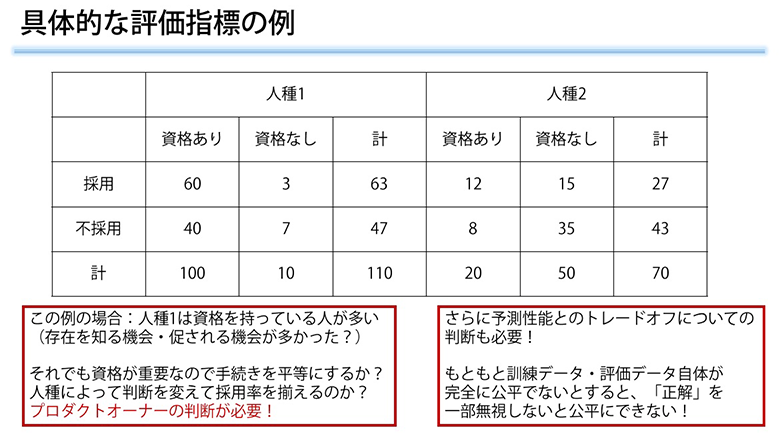

信頼できるAI提供に向けたAI品質管理の取り組み

NTTデータのデジタル社会基盤技術センタから、AI品質の課題に対するオファリングであるAI品質アセスメントやAI品質コンサルティングをプロジェクト支援向けに提供する活動を紹介しました。特にAI品質をチェックし改善する技術については、外部機関とも連携した継続的な開発を進めていることを説明しました。

図3:AI品質コンサルティングサービスのイメージ

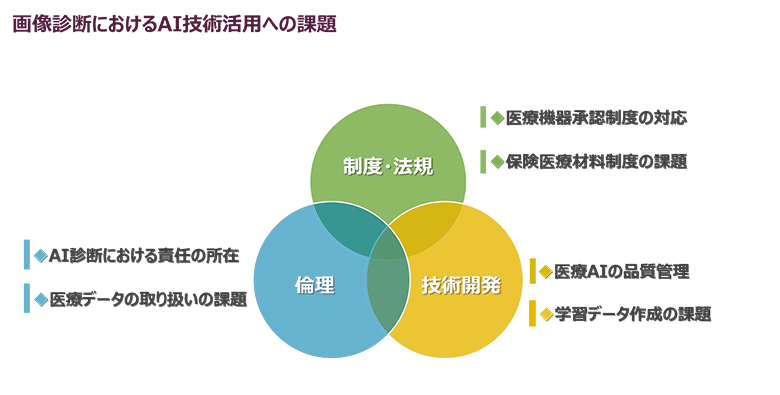

AI画像診断の実用化に向けた取り組みと課題

NTTデータのヘルスケアAIセンタから、放射線科医の業務を支援するAI画像診断技術を紹介しました。医師はX線やCT画像を大量に見て迅速に判断する必要があるため、その判断を助ける補助的な使い方をするものです。AIによる完全な自動化ではないものの、学習データ用意の際に医師の協力が必要な点や、AIを内包する医療機器としての法制度対応などの面で、課題があることを説明しました。

図4:AI画像診断の課題

活発な議論の一部をご紹介

1.説明可能AIの今後の見通しについて

AIの挙動説明にあたり、個別事例での判断方法や社会的合意において、どのような見通しで対応していくのが良いか議論を行いました。石川先生からは、技術の方向性は確立しており、新たな技術的なブレイクスルーを期待するよりは、様々な分野の専門家と会話したり、適正さを見直す運用を入れたり、実世界から学ぶ方向で、技術を使いこなしつつ現実的な落としどころを探ることが求められる、との見解をいただきました。

2.AIのミスリーディングのクリティカルさについて

実際にAIのミスリーディングがどのくらい問題になるのか、機械学習した内容に基づくAIの判断メカニズムと人への説明が一致しない場合のリスクや弊害について議論を行いました。石川先生からは、起きたこと自体に気付かず継続運用されてしまうため、実際にそれとわかる事例が申告されるケースはなかなか発生しない、という意見が述べられました。また、NTTデータ側からは、AI画像診断の場合は、最終的に医師の責任で判断を行うため直接的な問題は発生していないが、ICU(集中治療室)でAIがアラートを出すシステムにおいて、なぜアラートが出たのか理由の説明を求められた経験を語り、AIが判定を下すような使い方の場合に問題が起きるのでは、との意見が挙がりました。

3.消費者に向けた説明について

AIシステムを提供する側だけでなく、医者や人事部門などAI利用者側は、患者や採用応募者などAIによる判断を受ける消費者側に説明が必要になる点について、どのような対策が可能か議論を行いました。石川先生からは、元々説明が必要だった部分を人間が曖昧なまま対処してきたところがあり、AIだから課題になるポイントも考慮しつつ、従来の説明指針を引き継ぐ対処も考えられる、との見解を示されました。

最後に

今回の勉強会では、AIの学習データの偏りなどから品質や判断に不公平が生じてしまうことや、人々の潜在意識に含まれていた曖昧なバイアスがAIの判定で顕在化し、問題になることなどが示されました。この問題は技術的なアプローチだけでなく、業務シーンやユースケースごとに特性を理解して、適切な対応をしていく必要があります。NTTデータは、AIアドバイザリーボードでの議論結果を取り入れつつ、AI関連プロジェクトにおける問題発生を抑制するとともに、提供するAIソリューションの品質/信頼性を向上し、安心・安全なAIを利活用できる環境を整備していきます。