なぜAI規制が必要とされているか

AI・データ活用は、技術の進展に伴い、その活用範囲がサイバー空間から実世界へ大きく拡大しています。身近なところでは、広告表示やネット通販での商品のレコメンド、スマートフォンでの顔認証は日常的に使っているのではないでしょうか。他にも、自動運転や融資の審査、医療での画像診断など、AIの判定に何か誤りがあれば、その影響が人命や財産にかかわるような高い信頼性が求められる領域にもAIの活用は進んでおり、今後もビジネスや生活にさらに組み込まれていくと想定されます。

その一方で、AIの活用が拡がったことで、様々な問題も顕在化しています。

皆さんの身近でも安全対策のため防犯カメラの設置が進んでいるかと思いますが、撮影した画像に対する顔認識技術の適用にはプライバシーやバイアスの問題が指摘されています。例えば、2020年、アメリカでは監視カメラに映っていた万引き犯を、顔認識システムの照合結果により特定された人物を逮捕したところ、カメラに映っていた人物とは全くの別人でしかも事件当日のアリバイがあったという誤認逮捕の問題がありました。この年はブラック・ライブズ・マター問題があったこともあり、システムは利用停止となり、米国連邦議会では政府機関による顔認識の使用を禁じる法案が提出されました。

また、公的機関による審査にAIを適用する事例が特に海外で増えていますが、マイノリティーへの差別的な出力によるトラブルが発生しています。例えば、オランダ政府が2013年から運用していた育児給付詐欺検出システムでは、8年間で26,000もの無実の家族が誤って告発され、その多くは有色人種や移民などマイノリティーに属する人々だったそうです。この問題を受けて2021年に内閣は総辞職し、この後紹介するEUのAI規制法案で「公的機関によるソーシャルスコアリング」に強い規制をかけるきっかけを与えた1つの事件になったとのことです。

さらに最近は著名人の動画や音声を模倣するAI技術も出現していますが、これを悪用し、偽情報を拡散させて社会的な混乱を生じる問題も起きています。

以上のように、AIの適用に対しても、何らかの統制を設けないと、「人権侵害」「プライバシー侵害」などの問題を引き起こすことが見えてきました。

各国の国策動向:ポイントは人権、公正性

AI活用により様々な問題が起きたことを受け、数年前から政府レベルでAIに統制をかける動きが出てきました。

国際的な議論のはじまりは、2016年のG7サミットで日本が問題提起し、対策として「AI開発原則」のたたき台を示したのがきっかけと言われています。これを受けてOECD内に検討する会合が設置され議論が進み、2019年5月のOECDのAI原則や6月のG20サミットでの合意に繋がりました。この頃の原則には概ね「人間中心の価値観」「AIの出力に対するアカウンタビリティや透明性、公平性」「セキュリティやプライバシーの確保」といったことが書かれています。

このように、2019年頃までは原則やガイドラインを皆で守るソフトローの路線でしたが、2020年頃から欧米を中心に法規制強化の動きが出てきました。特に2021年4月にEUから公開されたAIの規制法案(AI Act)は、エポックメイキングなものとして注目されています。

EUのAI規制法案は、「リスクベース・アプローチ」によりAIを倫理の観点で4つのリスクにカテゴライズして対策を講じています。重視されているのは人権の保護、およびプロセスの透明性です。

「受容できないAI」は「人々の安全や権利に対して明らかに驚異のあるAIシステム」で、人の自由意志を妨げるサブリミナルや、公務のプロセスが不透明になる公的機関による社会的スコア利用が該当し、これらは原則、禁止とされています。

「ハイリスクAI」は「人々の安全や権利に悪影響を及ぼす可能性があるAIシステム」で、生命や身体に影響する医療や自動運転、機会均等であるべき人材採用などが該当し、これらには適合性評価として第三者認証の取得や提供者と利用者に運用上の義務を課されます。

「透明性義務を伴うAI」としては、ディープフェイクや感情推定といったAIが該当し、これらは人の誤認誘導とならないように、AIシステムを利用することの明示といった透明性の確保の義務が課されます。

本法案は、現在審議が進められていますが、例えば「受容できないAI」に分類される「潜在意識への働きかけ」を使うAIの定義の明確化や「ハイリスクAI」に分類される「遠隔生体識別システム」の定義から本人確認用途のものは明確に除外すべきといった企業や団体から様々な意見書が寄せられています。

アメリカでは、ハードロー(法的拘束力がある)とソフトロー(拘束力がない規範)を組み合わせた規制強化の動きが進んでいます。

ハードローの動きとして連邦政府ではプライバシーや金融、雇用など分野ごとに法規制を強化しています。特に現在審議中の「アルゴリズム説明責任法」は消費者の生活に重大な影響を及ぼす教育、雇用、金融サービス等における「自動意思決定システム」に対して「公平である」ことの透明性の義務を課すものになっています。この対象はAIを含めた機械処理が対象になっており、法規制の対象は広範囲に及びます。また、州や市政府でも独自にプライバシーや雇用におけるAI使用の規制強化が行われています。

一方、ソフトローとして、AIそのものについては、AI権利章典としてAIを用いたシステムを設計、使用する際に考慮すべき5つの原則が検討されています。また、NISTからはAIリスクマネジメントフレームワークのドラフトが公開されており、ここでは、市民の自由意志や身体的安全、差別、組織の評判やセキュリティ、グローバルな金融システムやサプライチェーンへの悪影響がリスクとして想定されています。

一方、日本国内では、総務省や経産省からAIの利活用における原則やガイドライン、および、各省庁からAIの出力の誤りが人命に直結する医療や自動運転、財産への影響が大きい金融分野別にガイドラインが出ていますが、画一的な法律化の動きは見られません。しかしながら、J-SOX法や外為法など欧米に追随して同様の法制化を進めたことはこれまでにも多数ありましたので、欧米の動向次第では日本でも何らかの法規制が進められることは想定できます。

AIは何がリスクとされているか

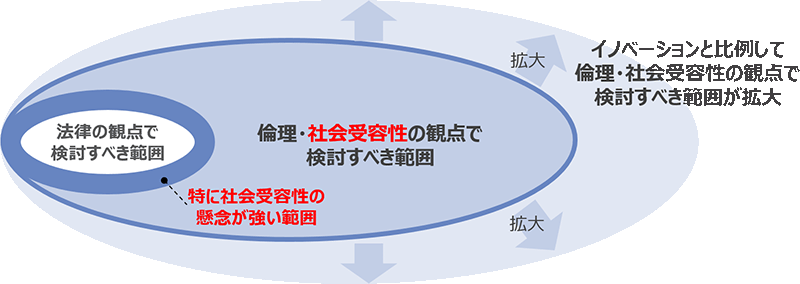

このように、AI活用における発生した様々な問題を踏まえて法規制の強化の動きが進んでいますが、冒頭に紹介した問題に共通するのは、たとえ法律に違反していなくても、「倫理・社会受容性」の観点から社会的な懸念が巻き起こって大きな問題となったものです。

こうした倫理・社会受容性に反するAI適用を行うと、その規模に関わらず、そのAIを提供した者にはレピュテーションの急激な低下を引き起こし、企業ではビジネスの継続に影響を生じるリスクがます。政府であれば国民からの信頼性の低下になり、国際的にも他国からの信頼性の低下、競争力の低下に繋がります。

以上を踏まえ、ITプロダクト、サービスを提供する事業者には、法整備動向を注視しつつ、今目の前にあるレピュテーションリスクのマネジメントについて独自で体制を整える必要があります。たとえ法規制に至らなくても、自社のガバナンス体制を整えるのは決して無駄にはなりません。